Eind verleden week is met veel bombarie een nieuwe versie van ChatGPT gelanceerd (o1-preview en o1-mini). Deze versie is nu in staat om te redeneren. In deze blogpost licht ik toe hoe dit werkt, en geef ik aan dat deze versie niet voor alle taken geschikter is dan de voorganger of, bijvoorbeeld, Claude 3.5. Sonnet. En zou je deze applicatie kunnen gebruiken voor het analyseren van vraagstukken van een organisatie?

De nieuwe modellen van OpenAI’s o1-modellen maken gebruik van ‘reinforcement learning‘ en ‘redeneer tokens’ waardoor de o1-modellen complexe problemen oplossen voordat ze antwoorden genereren. ‘Tokens’ zijn de kleinste eenheid van tekst die een model kan verwerken.

De modellen beschikken over een indrukwekkende contextvenster van 128.000 tokens, waarbij o1-preview tot 32.768 tokens per voltooide opdracht kan genereren en o1-mini zelfs tot 65.536 tokens. Deze limieten omvatten zowel zichtbare tokens van het resultaat als de verborgen tokens die gebruikt zijn bij het redeneren. Het vernieuwende aspect van deze modellen ligt in hun vermogen om een verborgen gedachtegang (‘chain of thought‘) te gebruiken, waarbij problemen in stappen worden opgedeeld. Dit simuleert redeneren, dat normaliter is voorbehouden aan mensen. Deze toepassing moet prestaties bij analytische taken aanzienlijk verbeteren.

De ‘redeneer tokens’ helpen de modellen om beter na te denken over vragen. Ze bekijken een vraag van verschillende kanten en bedenken meerdere manieren om te antwoorden. Dit werkt een beetje zoals een schaker die vooruit denkt over verschillende zetten. De modellen leren door oefening om steeds beter problemen op te lossen. Ze doen dit niet alleen tijdens het trainen, maar ook als ze echt aan het werk zijn. Zo kunnen ze ter plekke verschillende strategieën uitproberen om de beste oplossing te vinden. Redeneren via de ‘chain of thought‘ biedt volgens de ontwikkelaars ook nieuwe mogelijkheden voor afstemming en veiligheid.

Cijfers over prestaties van de o1-modellen zijn opmerkelijk. De modellen behalen onder andere het 49e percentiel in de Internationale Informatica Olympiade van 2024 en een score van 83,3% op het AIME-wiskundeexamen. Op het codeplatform Codeforces overtreffen ze 89% van de menselijke deelnemers. Dit is een aanzienlijke verbetering voor dit type taken, ten opzichte van eerdere modellen.

Technische uitdagingen zijn het balanceren van vooraf getrainde kennis met nieuwe redeneringen, het beheren van computationele kosten en het bepalen wanneer het redeneringsproces moet stoppen. Verder zijn de o1-modellen momenteel alleen beschikbaar voor ChatGPT Premium- en Teams-gebruikers, met wekelijkse limieten van 30 berichten voor o1-preview en 50 voor o1-mini. Een andere belangrijke beperking op dit moment is dat je deze versie niet online kunt laten zoeken en geen bestanden kunt uploaden om te analyseren. Dit zal, vermoed ik, in een volgende versie wel mogelijk worden.

(De samenvatting is grotendeels gebaseerd op de nieuwsbrief van AlphaSignal).

Anders ‘prompten’

Wat verder opvalt, is dat je op een andere manier opdrachten moet gebruiken. Bij de andere grote taalmodellen moet je uitgebreide ‘prompts’ gebruiken en het taalmodel bij voorkeur een persona laten ‘spelen’. Nu geeft OpenAI als tips:

- Houd instructies kort en duidelijk: Deze modellen begrijpen en beantwoorden korte, heldere opdrachten goed. Je hoeft niet uitgebreid uit te leggen.

- Vraag niet om stap-voor-stap uitleg: De modellen denken zelf al na. Je hoeft niet te vragen om “stap voor stap” te denken of hun redenering uit te leggen.

- Gebruik markeringen voor duidelijkheid: Zet verschillende delen van je vraag tussen aanhalingstekens of gebruik kopjes. Zo begrijpt het model beter welk deel wat betekent.

- Geef niet te veel extra informatie: Als je extra context geeft, kies dan alleen wat echt belangrijk is. Te veel informatie kan het antwoord ingewikkelder maken dan nodig.

Dit maakt het gebruik van grote taalmodellen wel complexer. Je moet steeds nadenken over wat voor type prompt je moet gebruiken.

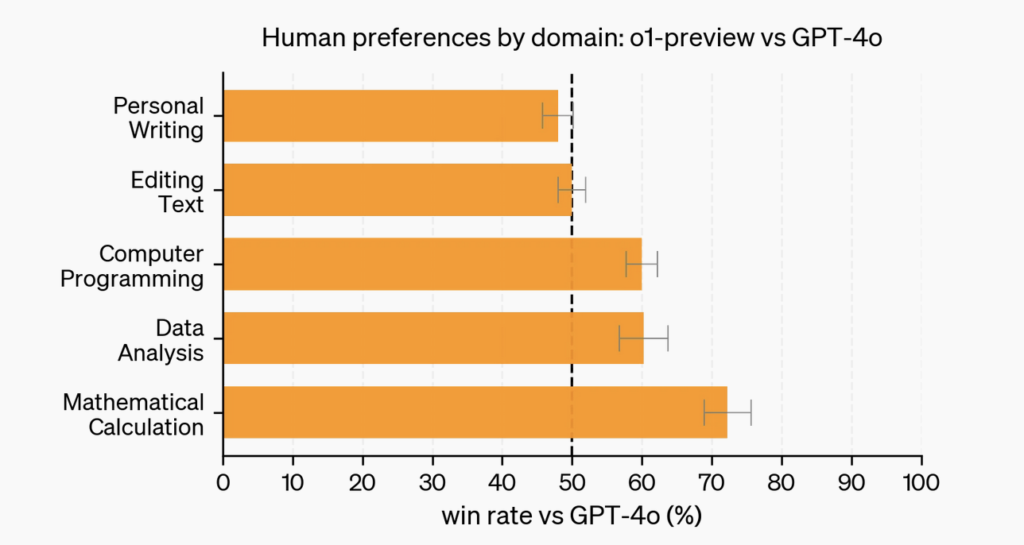

Het is namelijk niet zo dat de nieuwe taalmodellen in plaats van toepassingen zoals ChatGPT 4-o of Claude 3.5 Sonnet komen. De nieuwe taalmodellen zijn beter in het oplossen van complexe vraagstukken op het gebied van wiskunde, natuurkunde of informatica. Als het gaat om schrijfwerk zoals het maken van samenvattingen of het herschrijven van teksten, dan zijn andere applicaties meer geschikt. Dat blijkt ook uit de evaluatie van OpenAI naar voorkeuren van mensen naar ChatGPT 4-o versus o1:

Mijn eerste ervaringen

Ik heb een aantal keren opdrachten gegeven aan o1-preview en de output ook vergeleken met Claude 3.5 Sonnet. Over het algemeen scoren ze vergelijkbaar. Dat kan meerdere redenen hebben:

- Ik kwam er pas gisteren achter dat je verschillend moet prompten (zie hierboven). Ik gebruikte dus de traditionele prompt.

- Ik ben geen natuurkundige, wiskundige of informatica-specialist. De vraagstukken die ik gebruikte, zijn waarschijnlijk minder geschikt voor ChatGPT o1-preview.

Vanochtend heb ik de volgende prompt gebruikt:

Large language models have some limitations. First, using them takes a lot of energy. Secondly, they regularly reproduce biases because the data they are trained on contain many biases. These language models are highly evolving. Yet they do not really improve these two problems. Argue why developers are not solving these problems. Then describe how developers of large language models can solve these problems.

Het resultaat was meer volledig dan de output Claude. Bij een andere vraag naar de belangrijkste oorzaken van mislukte implementaties van leermanagement systemen produceerden Claude en ChatGPT o1-preview analyses die elkaar overlapten en aanvulden. Bij Claude heb ik een uitgebreide prompt gebruikt, bij ChatGPT o1-preview een beperkte prompt.

Generatieve AI voor probleemanalyse

Onlangs schreef ik over een onderzoek waaruit bleek dat generatieve AI -binnen een specifieke context- beter was in het genereren van ideeën voor het oplossen van problemen dan mensen. In een WhatsApp-groep krijg ik toen de vraag of je generatieve AI ook zou kunnen gebruiken voor het analyseren van grondoorzaken van problemen.

Nu verzorg ik in het kader van de FCe bacheloropleiding over e-learning al vele jaren een gastcollege over de implementatie van e-learning. In het kader daarvan vraag ik cursisten om op basis van een aantal artikelen een analyse te maken van een mislukt ‘i-pad-project’ in Californië. Ik heb die artikelen daarom in een document geplaatst. Ik heb vervolgens Claude 3.5 Sonnet met behulp van een uitgebreide prompt gevraagd een analyse te maken van de belangrijkste oorzaken van deze mislukking, op basis van het document.

De prompt was:

Het resultaat van de analyse was goed, en vergelijkbaar met het ‘model antwoord’ dat ik tijdens het college gebruik.

Op deze manier kun je dus generatieve AI gebruiken om grondoorzaken van vraagstukken te vinden. Toch zijn er m.i. twee belangrijke beperkingen:

- Problemen binnen organisaties kun je documenteren. Dat is veel werk en bovendien gaat het wellicht over bedrijfsgevoelige informatie die je niet wilt uploaden naar een generatieve AI-oplossing.

- De informatie over grondoorzaken kan ook weleens vooral impliciet of niet-tastbaar van aard zijn (tacit knowledge). Deze kennis is lastig te documenteren. Je kunt interviews gebruiken om de informatie meer tastbaar te maken.

De vraag is nu of de nieuwe versie van ChatGPT in staat is vraagstukken van een organisatie te analyseren. Op dit moment niet. Je kunt de applicatie immers niet voeden met contextspecifieke factoren. Zelfs als dit wel mogelijk wordt, gelden de twee beperkingen die ik hierboven heb genoemd. Uiteraard kun je wel het large language model voeden met geanonimiseerde data.

Ik ben op dit moment nog steeds niet overtuigd van de toegevoegde waarde van deze nieuwe versie voor de werkzaamheden waar ik generatieve AI voor gebruik. Ethan Mollick slaat echter de spijker op z’n kop als hij schrijft:

It is amazing, still limited, and, perhaps most importantly, a signal of where things are heading.

Meer weten over deze versie van ChatGPT?

- Problems solved by ChatGPT (O1)

- Critical thinking was famous 21st C skill – now it’s an AI skill

- Learning to Reason with LLMs

- Something new on OpenAI’s strawberry and reasoning

- Introducing OpenAI O1 Preview

- OpenAI Releases Reasoning Models/Abilities

Mijn bronnen over (generatieve) artificiële intelligentie

Deze pagina bevat al mijn bijdragen over (generatieve) artificiële intelligentie, zoals ChatGPT.

Andere bronnen over generatieve AI

- Researchers test ChatGPT, other AI models against real-world students

- The AI-Copyright Trap

- AI is a provocation – that explains a lot of the debate

- Agentic AI: AI Agents – The New Workforce We’re Not Quite Ready For

- 7 New and Improved Things You Can Do with AI in Education

- I Have AI Fatigue. Here’s What I’m Doing to Overcome It

- OpenAI’s Project Strawberry will become ChatGPT5, launch soon, insiders say

- OpenAI Unveils Orion: The Next Leap in AI with GPT-5 ‘Strawberry’ Technology

- Suggestions for using AI in education

- Google researchers used AI to create fake podcasts for training other AIs

- AI Is Already Advancing Higher Education

- The Most Popular AI Tools for Instructional Designers

- Kunnen chatbots studenten en docenten helpen bij leren en onderwijs?

- AI als procesbegeleider: een verrassend succesvol experiment in het hoger onderwijs

- Salesforce unveils AgentForce to help create autonomous AI bots

- 3 steps to eliminate shadow AI

- Things I was wrong about pt 4 – AI

- OpenAI O1 Crushes PhD-Level Experts in Wide-Ranging Knowledge Test

- OpenAI lanceert O1 Preview en O1 Mini

- Microsoft AI: Interview with BBC Executive Lounge

- Sadly, Bill Gates Continues To Demonstrate His Cluelessness About How Education Works

- Is AI Making Degrees Useless? White Collar Job Market Disruption

- Why agents are the next frontier of generative AI

- Can AI Dream About Emotions?

- Using AI to mark students’ work: Postscript

- I Have Been Hallucinated

- My God, I Can’t Believe How Much Time ChatGPT Is Now Going To Save Me In Creating One Of My Favorite Teaching Resources

- I Created 25 Podcasts Over the Weekend

- An AI tutor helped Harvard students learn more physics in less time

This content is published under the Attribution 3.0 Unported license.

Geef een reactie