Chris Goodall heeft een document gemaakt waarin hij een aantal van de belangrijkste AI-cases binnen het onderwijs heeft gecategoriseerd, inclusief het risiconiveau en de risicobeperkende maatregelen die medewerkers kunnen treffen. Je kunt je daarbij afvragen of die risico’s niet ook gelden bij ‘mensenwerk’. Toch snap ik als mensen risico’s van mensenwerk niet zomaar vergelijken met risico’s die AI met zich meebrengt. Ik beschrijf dit vanuit drie perspectieven.

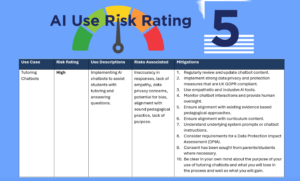

Een van de toepassingen van AI is het creëren van op maat gemaakte leermiddelen. AI-algoritmen kunnen snel lesplannen, presentaties en oefeningen genereren, afgestemd op de specifieke behoeften van lerenden. Het gevaar is echter dat deze inhoud onnauwkeurig is of vooroordelen kan bevatten kan zijn. Daarom is het belangrijk dat een docent altijd de AI-output controleert en waar nodig aanpast. Dit risico schat Goodall als laag in.

De tweede toepassing is het gebruik van AI voor het communiceren met ouders en voor het schrijven van rapporten. Dit risico schat Goodall als laag tot gemiddeld in. Het risico is dat je overmatig afhankelijk wordt van AI, dat communicatie onpersoonlijker wordt en dat je te maken kijkt met privacyproblemen. Je kunt dit onder meer tegen gaan door alle door Al gegenereerde rapporten en e-mails voor ouders te personaliseren, data van lerenden te anonimiseren en modellen niet te trainen met echte data.

De derde toepassing is het analyseren van gegevens van lerenden met behulp van AI. Het automatisch verwerken van grote hoeveelheden data geeft docenten waardevolle inzichten. Het middelgrote risico is echter verkeerde interpretatie van data, en aantasting van privacy van lerenden. Waarborg deze privacy te allen tijden, kies bijvoorbeeld voor AI-tools met sterke beveiligingsmaatregelen en gebruik alleen geanonimiseerde gegevens.

Een vierde toepassingsgebied met een medium/hoog risico is beoordeling en feedback. AI kan helpen bij het nakijken van werk en het geven van gedetailleerde terugkoppeling. Valkuilen zijn onder meer mogelijke bias in de beoordeling of het schenden van intellectueel eigendom. Lerenden en ouders moeten weten wanneer AI wordt ingezet. Ook zul je om toestemming moeten vragen om werk van lerenden te mogen uploaden. En de docent blijft altijd eindverantwoordelijk voor het beoordelingsproces.

De vijfde en laatste toepassing die Goodall bespreekt is de inzet van AI-chatbots voor persoonlijke begeleiding. Deze ‘digitale tutoren’ kunnen lerenden 24/7 ondersteunen. Maar ook hier geldt: waakzaamheid is geboden. Zijn de adviezen inhoudelijk correct? Kan de chatbot wel voldoende empathie tonen? Strookt de geboden hulp met bewezen pedagogisch-didactische methoden? Voortdurende monitoring en bijsturing door docenten is noodzakelijk.

In één van de WhatsApp-groepen over AI, waar ik lid van ben, werd aangegeven dat veel van deze tekortkomen ook gelden voor mensen. Mensen geven ook weleens foutieve informatie en kunnen bevooroordeeld zijn, of fouten maken ten aanzien van privacy. Waarom kijken we kritisch naar de tekortkomingen van AI, terwijl we de tekortkomingen van mensen voor lief lijken te nemen? Volgens mij zijn daar verschillende redenen waarom mensen meer moeite lijken te hebben met de risico’s en tekortkomingen van AI dan met die van mensen. Ik bespreek drie invalshoeken.

1. Ethische theorieën

Vanuit verschillende ethische theorieën kan dit als volgt beredeneerd worden:

- Vanuit de deontologische ethiek kun je stellen dat mensen bepaalde morele plichten en verantwoordelijkheden hebben. Een AI systeem heeft geen intrinsiek plichtsbesef. Als een AI systematisch fouten maakt of vooroordelen vertoont, is het moeilijker iemand daar verantwoordelijk voor te houden dan wanneer een mens zulke fouten maakt. Een mens kan aangesproken worden op zijn morele plicht zorgvuldig en onbevooroordeeld te handelen.

- Vanuit de consequentialistische ethiek kun je redeneren dat de gevolgen van systematische AI fouten in potentie een veel grotere negatieve impact hebben. Een menselijke tutor die fouten maakt, benadeelt een beperkt aantal lerenden. Maar fouten of bias in een op grote schaal gebruikt AI tutoring systeem heeft effect op veel meer lerenden. De risico’s van AI zijn dus mogelijk ernstiger.

- Als je kijkt naar de deugdethiek, die focust op morele karaktereigenschappen, dan kun je stellen dat mensen, ondanks hun tekortkomingen, in ieder geval kunnen streven naar deugden als rechtvaardigheid, zorgvuldigheid en wijsheid. Een AI-toepassing bezit zulke deugden niet. Je kunt een AI systeem niet vertrouwen vanuit het ‘goede karakter’. Dit voedt wantrouwen in AI.

- Als je zorgethiek als uitgangspunt neemt, dan kun je de grotere zorgen ten aanzien van AI verklaren vanuit het belang van de zorgrelatie. De tekortkomingen van een betrokken menselijke tutor wegen minder zwaar dan de fouten van een ‘kille’ AI, omdat een menselijke tutor als het goed is een relatie met de lerende heeft. De AI-toepassing heeft die relatie niet.

2. Kritiek op solutionisme

Een tweede invalshoek is die van kritiek op het ‘solutionisme‘. Deze term is populair geworden dankzij technologiecriticus Evgeny Morozov. De term verwijst naar de overtuiging dat technologie de oplossing biedt voor veel, zo niet alle, maatschappelijke problemen. Binnen deze visie worden complexe sociale en politieke kwesties vaak gereduceerd tot technische problemen met technische oplossingen. Critici stellen dat complexe problemen worden teruggebracht tot eenvoudige, technische vraagstukken. Diepere oorzaken van problemen worden niet aangepakt, en er wordt vaak weinig rekening gehouden met de mogelijke negatieve gevolgen van technologische oplossingen. Verder wijzen critici erop dat technologie controle en surveillance kan versterken, wat kan leiden tot een beperking van persoonlijke vrijheid en privacy. Critici van het solutionisme wijzen er daarnaast op dat technologische oplossingen soms worden gebruikt om gedrag te monitoren en te sturen op manieren die niet altijd ethisch verantwoord zijn. Bovendien legt digitalisering veel macht in handen van techbedrijven die oplossingen ontwikkelen. Commerciële belangen wegen dan zwaarder dan publieke waarden. Gerelateerd aan het gebruik van AI binnen het onderwijs: er bestaat bijvoorbeeld vrees dat de bestrijding van het lerarentekort wordt gereduceerd tot het gebruik van AI die docenten taken uit handen moet nemen, terwijl dit om een veel complexer probleem gaat. Critici van AI-solutionisme benadrukken als reactie de tekortkomingen van AI.

3. Grenzen aan de mate waarin mensen geholpen willen door of willen interacteren met computers

Ik heb eerder geschreven dat er waarschijnlijk grenzen zijn aan de mate waarin mensen geholpen willen worden door of willen interacteren met een computer. Volgens de “Uncanny Valley” theorie is er een punt waarop een robot of een computerinterface te menselijk begint te lijken en daardoor afstotend kan werken of onbehagen veroorzaakt bij mensen. Dit geldt mogelijk niet voor iedereen, en wellicht gaat dit ook veranderen als de kracht van generatieve AI toeneemt.

Mijn bronnen over (generatieve) artificiële intelligentie

Deze pagina bevat al mijn bijdragen over (generatieve) artificiële intelligentie, zoals ChatGPT.

This content is published under the Attribution 3.0 Unported license.

Geef een reactie